هوش مصنوعی بدون محدودیت اخلاقی؛ بایدها و نبایدها

هوش مصنوعی به یکی از فناوریهای محوری زندگی تبدیل شده که تأثیرات زیادی بر جنبههای مختلف فردی و اجتماعی بشر گذاشته و البته همزمان با رشد تواناییهای فنی، پرسشها دربارهی محدودیتهای اخلاقی هوش مصنوعی هم رو به افزایش است.

هنگام استفاده از مدلهای هوش مصنوعی مولد، همیشه این پرسش مطرح است که تا چه حدی باید برای دریافت دادهها و ارائهی پاسخ محدودیت گذاشت و آیا در نهایت میتوان مفهوم هوش مصنوعی بدون سانسور یا هوش مصنوعی بدون محدودیتهای اخلاقی را پذیرفت؟ در حالی که عدهای در جستوجوی راههایی برای دور زدن محدودیتهای اخلاقی هوش مصنوعی هستند، برخی دیگر به اهمیت چارچوبها و نظارت در توسعهی این فناوری تأکید میکنند.

در این مطلب با نگاهی به محدودیتهای اخلاقی هوش مصنوعی، امکان وجود هوش مصنوعی بدون محدودیت اخلاقی واقعی، دلیل تمایل به دور زدن محدودیتها و پیامدهای آن را بررسی میکنیم.

محدودیتهای اخلاقی هوش مصنوعی

هوش مصنوعی بدون محدودیت اخلاقی

دور زدن محدودیت هوش مصنوعی

پیامدهای دور زدن هوش مصنوعی

راهکارهای حفظ محدودیتهای مؤثر هوش مصنوعی

جمعبندی

محدودیتهای اخلاقی هوش مصنوعی

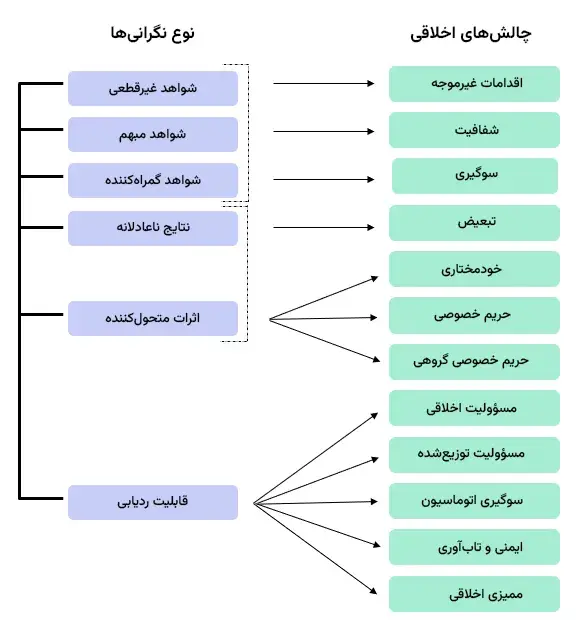

هوش مصنوعی به خودی خود، از مفاهیم اخلاقی و اصول آن به مفهوم عمیق انسانی چیزی نمیداند، بلکه چون زادهی خلاقیت و علم انسان است، محدودیتهای آن هم به قواعد، چارچوبها، و اصولی گفته میشود که توسعهدهندگان، قانونگذاران یا سازمانهای بینالمللی برای جلوگیری از آسیب، تبعیض، خطرات امنیتی، نقض حقوق انسانها و سوء استفاده از ابزارهای هوش مصنوعی وضع کردهاند.

از جمله موارد مهم در بحث اخلاقیات هوش مصنوعی، حریم خصوصی و حفاظت از دادههاست. دادههای استفاده شده برای آموزش مدلها، ممکن است شامل اطلاعات حساس یا شخصی باشند. بنابراین تضمین اینکه جمعآوری دادهها با رضایت افراد صورت گرفته باشد و استفادهی آنها کنترلشده باشد، اهمیت پیدا میکند.

عدالت و پرهیز از تبعیض میان گروهها و افراد مختلف بحث اخلاقی دیگری است که برای هوش مصنوعی مطرح میشود. دادههای آموزشی اغلب سوگیریهایی دارند و اگر این سوگیریها در هوش مصنوعی تقویت شوند یا مدلها به طور ناعادلانه برای گروههای آسیبپذیر تصمیم بگیرند، پیامدهای اخلاقی بزرگی دارد.

از سوی دیگر، شفافیت و توضیحپذیری در مدلهای هوش مصنوعی اهمیت زیادی دارد چون تصمیمات مدلها گاهی برای کاربران «جعبه سیاه» محسوب میشوند و دلیل یک خروجی خاص مشخص نیست. در چنین شرایطی و با بروز خطا، ایمنی و مسؤولیتپذیری هم اهمیت پیدا میکند تا معلوم باشد که چه کسی پاسخگو است و همچنین باید روشها و فرآیندهایی برای جبران وجود داشته باشد.

ارزشهای بنیادین بشری مانند آزادی بیان، کرامت انسانی، داشتن اختیار و استفاده نشدن از هوش مصنوعی عمومی در کاربردهای ضدبشری یا نظارت غیرموجه هم جزو محدودیتهایی هستند که به طور گسترده پذیرفته شدهاند. برخی محدودیتهای کاربردی دیگر هم به دلیل مخاطرات اجتماعی، زیستمحیطی یا قانونی در حوزههایی مثل نظارت گسترده یا تصمیمگیری قضایی بدون نظارت انسانی مورد توجهند.

هوش مصنوعی بدون محدودیت اخلاقی

از نظر فنی، هر سیستمی محدودیتهایی دارد که هم شامل محدودیت فنی از جمله داده، توان محاسباتی، پیچیدگی و هم شامل محدودیت اخلاقی میشود که طراحی و قوانین بیرونی آن را تعیین میکند. در حقیقت، صحبت از هوش مصنوعی بدون محدودیت اخلاقی، معمولا اشاره به سامانهای مبتنی بر هوش مصنوعی است که بتواند قوانین اخلاقی را دور بزند یا از نظر محتوا، بدون قید و بند عمل کند.

چون مدلهای هوش مصنوعی در حوزههای مختلف کاربرد دارند، نگاه به اخلاق هم در آنها طبقهبندی متفاوتی دارد و برخی مرزهای بازتری را برای تولید محتوای ماشینی در نظر گرفتهاند. با این وجود حتی مدلهای با آزادی بیشتر هم به دلایل قانونی، اخلاقی، تجاری یا اجتماعی مرزهایی دارند و از جملهی آنها میتوان به ممنوعیت محتوای آسیبزا، سوء استفاده از کودکان، صراحت و خشونت جنسی، نقض حقوق دیگران و نژادپرستی اشاره کرد.

به نظر میرسد که این روند تا کنون مورد پذیرش غالب کاربران و نظارتکنندگان هم بوده و حتی در برخی زمینهها، صراحت بیشتر و تغییر نگاه مدلهای هوش مصنوعی به اصول اخلاقی، جنجالبرانگیز هم شده است. از جمله گوگل پیش از این وعدهی استفاده نکردن از AI در زمینهی تسلیحاتی یا نظارت و کاربردهای آسیبزا داده بود اما اکنون برخی از این موارد را در راهنمای خود تعدیل یا حذف کرده است و این یعنی فشارها یا اولویتهای متغیر، میتواند محدودیتهای اخلاقی فعلی را تضعیف کند.

گاهی نگرانی خود شرکتها باعث محدودیت در انتشار مدلهای هوش مصنوعی میشود. از جمله OpenAI که نسخهی کامل GPT-2 را به دلیل نگرانی از کاربردهای زیانبار آن، با تأخیر عرضه کرد. چنین تصمیماتی برای داشتن نظارت بیشتر بر محدودیتهای فنی و اخلاقی است. با این حال باز هم ممکن است پاسخهای هوش مصنوعی از کنترل سازندگان هم خارج شود. الگوریتمهایی که به درستی و به صورت جامع، هشدارهای بهداشتی، دادههای اقتصادی یا دادههای مرتبط با اقلیتها را بازتاب ندهند، به نتایج ناعادلانهای منجر میشوند که نشان میدهد محدودیتهای اخلاقی در آموزش مدلها در نظر گرفته نشده است.

دور زدن محدودیت هوش مصنوعی

میل به شکستن محدودیتها همیشه در انسان وجود دارد و حتی در زمینهی اخلاقی نمیتوان آن را نادیده گرفت. دلایل زیادی وجود دارد که کاربران بخواهند حتی محدودیت اخلاقی سرویسهای هوش مصنوعی را دور بزنند. برخی معتقدند محدودیتها یا سانسور، مانع خلاقیت، آزادی بیان و دسترسی کامل به اطلاعات میشوند و به همین دلیل از هوش مصنوعی بدون سانسور یا هوش مصنوعی بدون محدودیت استقبال میشود.

برخی دیگر تنها از روی کنجکاوی یا سرگرمی و درک مرز محدودیتهای سیستم، به دنبال دور زدن آنها هستند. ضمن اینکه انگیزههای اقتصادی یا سیاسی هم نقش مهمی دارند. از سوی دیگر کاربرانی که محتوایی ورای قوانین و اخلاق عمومی میخواهند، از جمله تبلیغات جنسی، نفرتپراکنی، اخبار دروغ، تبلیغات مخرب یا ابزارهایی برای دسترسی به هک، ممکن است به دنبال دور زدن محدودیتها و فعالیت آزادانهتر باشند.

دور زدن محدودیتها ممکن است منطقیتر هم به نظر برسد. وقتی کاربران احساس کنند نهادها یا شرکتها ممکن است منافعی داشته باشند یا معیارها شفاف و عادلانه نباشند، اعتماد کاهش پیدا میکند و تمایل به استفاده از سیستمهای موسوم به «هوش مصنوعی بدون محدودیتهای اخلاقی» افزایش مییابد. در نهایت، تفاوت در قوانین میان کشورها و پلتفرمها و ضعف در نظارت اجرایی، فرصتی را فراهم میکند که برخی افراد از شکافها در جهت اهداف خود استفاده کنند.

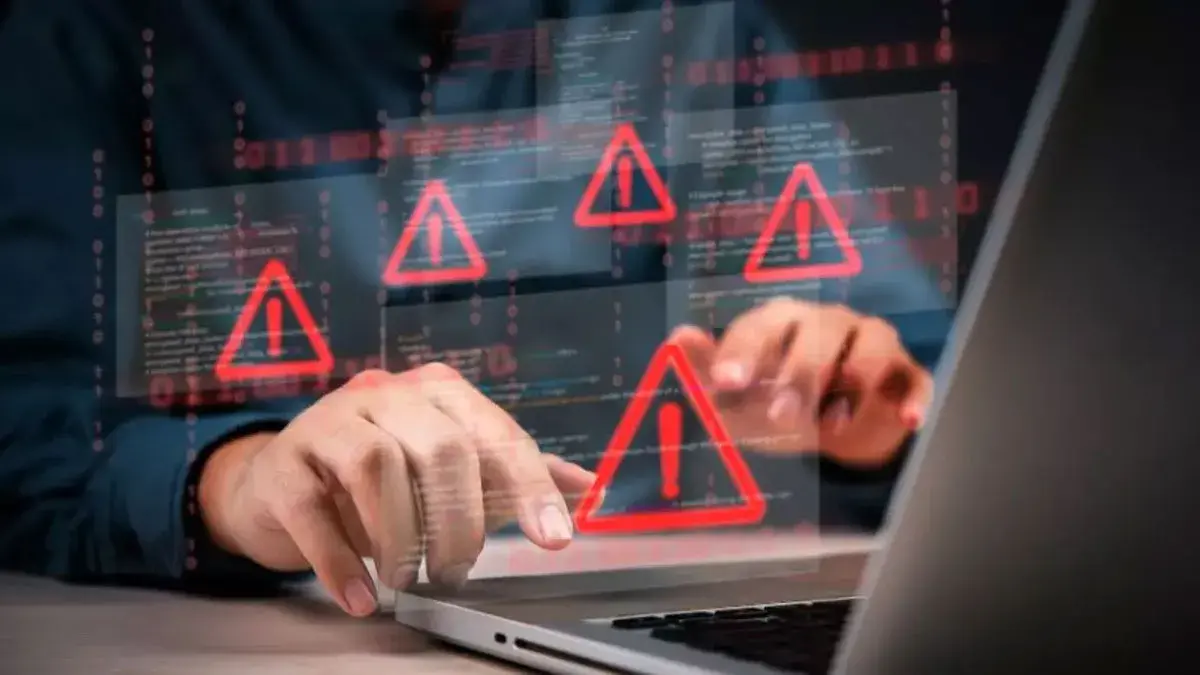

پیامدهای دور زدن محدودیتهای اخلاقی هوش مصنوعی

فراتر رفتن از محدودیت اخلاقی هوش مصنوعی، میتواند پیامدهای مختلفی داشته باشد. اگر این دور زدن مسؤولانه و هدفمند انجام شود که در زمینههایی مانند پژوهش و نوآوری علمی، هنر و ادبیات، آزمایشهای ایمنی و کشف باگ، آزادی بیان و عدالت الگوریتمی کاربردی است، فراتر رفتن از محدودیتهای بیش از حد محافظهکارانهی برخی مدلهای هوش مصنوعی، میتواند مثبت باشد.

با این حال در اغلب موارد دور زدن این محدودیتها نتایج ناخوشایندی به همراه خواهد داشت. از جمله باعث گسترش تبعیض و نابرابری، مثلا در سرویسهای سلامت، بیمه یا اشتغال میشود، نقض حقوق مدنی و انسانی مثل حریم خصوصی و آزادی بیان را به دنبال دارد و علاوه بر این، احتمال سوء استفادههای امنیتی و جرایم سایبری، انتشار محتوای نفرتپراکنی یا اخبار جعلی، جعل هویت و آسیب به افکار عمومی بسیار بالا میرود.

در نهایت کاهش اعتماد عمومی به فناوری، شرکتها و نهادهای نظارتی و هزینههای مالی و حقوقی ایجاد شده برای آنها هم از پیامدهای احتمالی مهم دور زدن محدودیتهای اخلاقی هوش مصنوعی است.

راهکارهای حفظ محدودیتهای اخلاقی مؤثر

برای مؤثر بودن چارچوبهای اخلاقی هوش مصنوعی، باید مقررات روشن و الزامآوری وضع شوند. وجود نهادهای نظارتی مستقل برای نظارت بیرونی، گزارشدهی شفاف، امکان حسابرسی و پاسخگویی شفاف میان شرکتها، دولتها و جامعهی مدنی هم در این زمینه بسیار مهم است. مشارکت فعال کاربران و اقلیتها و گروههای آسیبپذیر، باید در طراحی این محدودیتها لحاظ شود تا اصول اخلاقی هوش مصنوعی بازتابدهندهی واقعیتهای اجتماعی و فرهنگی باشند.

نمونهی برجستهی این تلاشها قانون هوش مصنوعی اتحادیه اروپا (EU AI Act) است که در سال 2024 تصویب و در آن ضمن طبقهبندی ریسک، الزامات ایمنی و شفافیت برای توسعهدهندگان و ارائهدهندگان سیستمهای هوش مصنوعی تعیین شد.

از سوی دیگر آموزش و آگاهیبخشی به توسعهدهندگان، کاربران و قانونگذاران، دربارهی پیامدهای واقعی هوش مصنوعی بدون محدودیت اخلاقی ضروری است. در طراحی سیستمها هم باید از ابتدا اصولی مانند حفظ حریم خصوصی، عدالت، شفافیت و قابلیت توضیحپذیری تعبیه شود و امکان نظارت انسانی، توقف یا بازگرداندن تصمیمات سیستم در شرایط خطا یا سوء استفاده به طور کامل فراهم باشد. علاوه بر اینکه باید سازوکار پاسخگویی و جبران خسارت هنگام آسیب هم در نظر گرفته شود.

هوش مصنوعی بدون محدودیت اخلاقی؛ جمعبندی

در نهایت باید در نظر داشت که چارچوبهای اخلاقی و هنجارها موضوعی نسبی است و میتواند از جامعهای به جامعهی دیگر و از نسلی به نسل دیگر تغییر کند. شاید به همین دلیل است که هنوز قوانین و چارچوبهای کاملا مشخصی برای هوش مصنوعی وضع نشده است اما هنجارهایی که به صورت عمومی در سراسر جهان امروز پذیرفته شدهاند و قوانین کلیتر، میتوانند مبنایی برای چارچوبهای اخلاقی هوش مصنوعی در نظر گرفته شود.

چارچوبهایی که به طور خودکار از سوی اغلب کاربران رعایت میشود و ابزارهای هوش مصنوعی هم به عنوان ساختههای همین جامعه با رعایت آنها برنامهنویسی و پایهگذاری شدهاند. اما برای تکمیل این روند، داشتن قوانین شفاف و قابل اجرا، امکان نظارت انسانی بر ساختار مدلهای هوش مصنوعی و طراحی روند جبران خسارت، میتواند اطمینان دهد که محدودیتهای اخلاقی نه مانع نوآوری، بلکه پایهای برای پیشرفت مسؤولانهتر هوش مصنوعی هستند.

عکس کاور: طرحی گرافیکی از محدودیتهای هوش مصنوعی

Credit: University of Missouri

منابع: Council of Europe, The Verge, UNESCO, The Conversation